OpenAI:对 GPT-4 的微调也将于秋季到来。

今天,OpenAI 又迎来了一次新的产品升级。

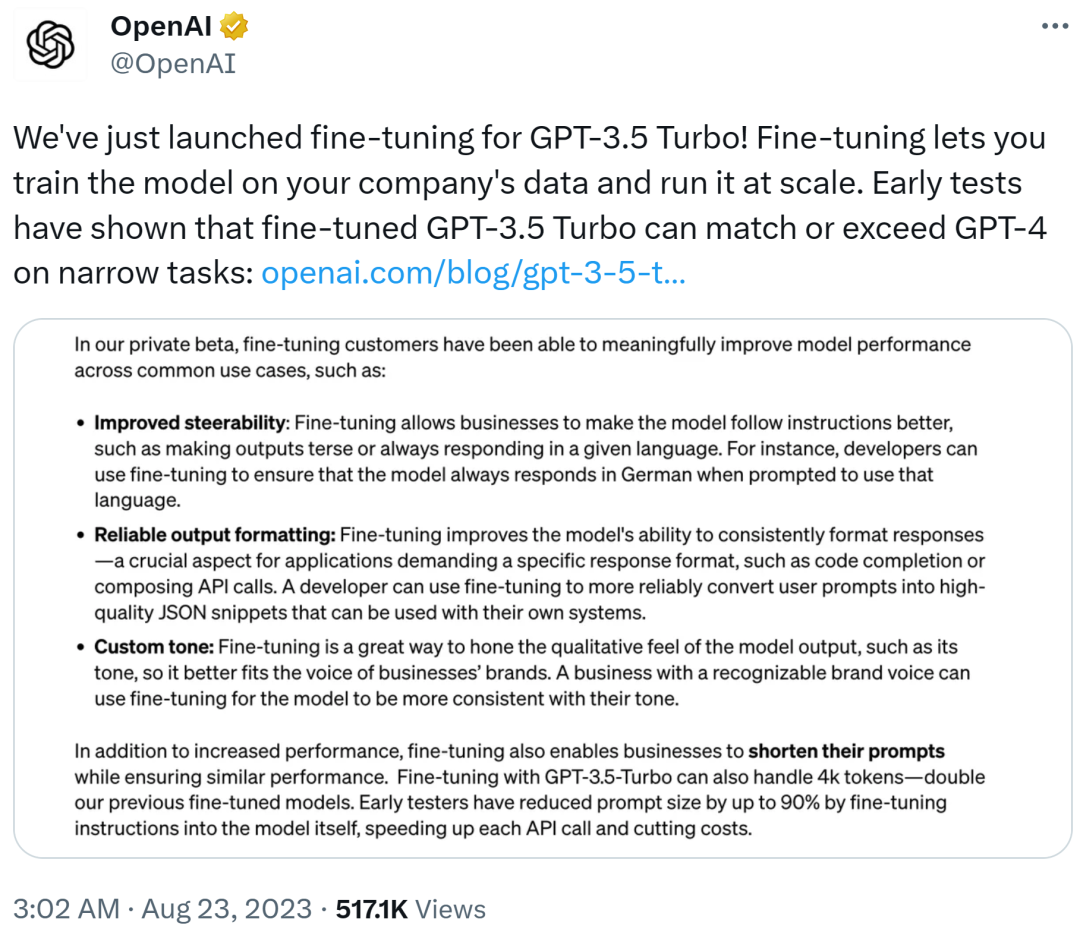

现在企业客户终于可以对 GPT-3.5 Turbo 进行微调了。这样一来,开发人员能够得到在自己的用例上表现更好的自定义模型,并大规模地运行这些模型。

至于实际效果,早期测试已经证明,GPT-3.5 Turbo 微调版本的能力在一些小范围任务上可以媲美甚至超越基础 GPT-4 模型。

OpenAI 表示,此次微调 API 的传入和传出数据完全归客户所有,它自己或任何其他机构都不能使用这些数据来训练其他模型。这一做法保证了客户数据的安全性和隐私性。

对于 GPT-3.5 Turbo 支持微调功能,英伟达 AI 科学家 Jim Fan 表示,这是 OpenAI 自 APP Store 之后最重要的产品升级。

微调后性能更强、提示更短、速度更快

自 GPT-3.5 Turbo 推出以来,开发人员和企业一直要求可以自定义该模型,以此创建独特和差异化的用户体验。

随着 OpenAI 宣布支持微调功能,开发人员现在可以运行监督微调,使得 GPT-3.5 Turbo 在一些常见用例上输出更好的结果。

首先增强了可控性。微调后的模型可以更好地遵循指令,比如输出简洁或者使用给定语言进行响应。举个例子,开发人员可以利用微调保证在提示使用德语时,始终以德语进行回答。

其次保证可靠的输出格式。微调提升了模型输出一致性格式的能力,这对于代码补全或生成 API 调用等要求特定响应格式的应用来说很重要。开发人员可以通过微调更可靠地将用户提示转换为高质量的 JSON 代码片段,以供自己的系统使用。

最后是自定义语气。微调是「磨炼」模型输出语气的好方法,以此更适合企业品牌声音。拥有知名品牌声音的企业可以通过微调,让模型输出与自身调性更加一致。

除了性能更强,微调后的 GPT-3.5 Turbo 模型可以在缩短提示的同时保证性能不会大变。此外微调后可以处理 4k token,这是 OpenAI 以往微调模型的两倍。早期测试人员在对模型指令进行微调时, 提示大小最高可以缩短 90%,从而加快了每个 API 调用的速度,减少了成本。

当与提示工程、信息检索和函数调用等其他技术结合使用时,微调将变成超级强大的工具。OpenAI 还表示,今天秋季还将支持对函数调用和 gpt-3.5-turbo-16k 的微调。

微调一般分为四步完成:准备数据、上传文件、创建一个微调任务和使用一个微调模型。

安全性也非常重要。为了在微调过程中保证默认模型的安全性,微调训练数据通过了 OpenAI 的审核 API 和 GPT-4 支持的审核系统,从而检测出与其安全标准相冲突的不安全训练数据。

价格有点贵

GPT-3.5 Turbo 的微调成本分为两部分,包括初始训练成本和使用成本。其中:

训练阶段:1K Tokens 要 0.008 美元

使用输入:1K Tokens 要 0.012 美元

使用输出:1K Tokens 要 0.016 美元

举个例子,如果要对 10 万 tokens 的训练文件进行微调,并训练 3 个 epochs,则预计成本为 2.40 美元。

对此,有人表示,价格有点小贵,是基础 GPT-3.5 模型的 4 倍了。

博客链接:https://openai.com/blog/gpt-3-5-turbo-fine-tuning-and-api-updates

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。